Oramai si sente parlare quotidianamente di Intelligenza Artificiale (IA) conosciuta più con l’acronimo inglese AI e Machine Learning (ML). Queste tecnologie a nostra insaputa sono già parte della nostra quotidianità da molti anni e lo saranno sempre più nei prossimi, basti pensare agli annunci pubblicitari mirati e personalizzati, alle verifiche fiscali ed assicurative, solo per citarne alcuni. Fino ad una decina di anni fa queste tecnologie venivano utilizzate al più per il riconoscimento di oggetti, trasformazione di scansioni di testi in testo, per la classificazione di clienti sulla base degli acquisti (carte fedeltà), etc. ma negli ultimi dieci anni abbiamo avuto un’impennata delle possibilità, questa consentita sia dall’enorme velocità di calcolo raggiunta, sia dai nuovi e più complessi modelli sviluppati; esempio lampante è l’IA generativa (GAN), che può essere utilizzata per creare un media semplicemente da una descrizione testuale. Una IA in grado di interagire attivamente ed in tempo reale fino a pochi anni fa era una chimera, ora é realtà. Le possibilità di queste tecnologie appaiono illimitate, alcune fantastiche (ad esempio riconoscimento di masse tumorali e altre malattie in stadi precocissimi), altre meno, ma cos’è e come funziona l’IA?

IA e ML (che è di fatto una sottobranca dell’IA) sono essenzialmente modelli matematici numerici (che non possono prescindere da un calcolatore ed essere espressi in modo analitico). Gli algoritmi di ML svolgono in generale una classificazione in classi precostituite (apprendimento supervisionato) o autogenerate (apprendimento non supervisionato).

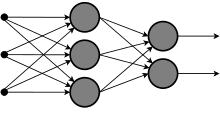

La ricerca alla fine degli anni’50 del secolo scorso, prese spunto dal funzionamento delle cellule del cervello, i cosiddetti neuroni. Questi di base prendono, attraverso i dendriti, gli impulsi elettrici in ingresso provenienti da altri neuroni e danno un impulso di uscita basato sulla composizione dei diversi segnali d’ingresso e delle soglie che man mano si adattano alla rete di cui fanno parte: l’unione di miliardi di queste piccole unità permettono i ragionamenti, l’espressione ed il controllo del movimento. Analogamente l’IA ha fondamento sulla concatenazione di elementi di processo elementari per costituire una rete articolata al fine di svolgere sempre una predizione di classe, ma in domini sempre più articolati e complessi (in gergo si dice che i confini tra una classe ed un’altra non sono lineari).

Analogamente l’ elemento di processo base di questa rete, detta “neurale” (artificiale), il percettrone, svolge un lavoro simile al neurone del nostro cervello e la rete che ne deriva non è altro che la composizione di queste unità elementari interconnesse tra loro. Per imparare a svolgere un compito specifico l’IA oltre a dover essere strutturata prima in modo adeguato (spesso in modo molto empirico), ha bisogno di un addestramento. Lo scopo dell’addestramento è di fatto aggiustare i pesi che ogni percettrone assegna per ogni suo ingresso in modo che l’errore finale di predizione si riduca al minimo. Questa operazione richiede un grande numero di esempi (il cosiddetto training set), soprattutto strettamente inerenti al compito e di qualità (la prima classificazione viene comunque eseguita da operatori umani), per poter avere un errore basso e quindi un’alta affidabilità di funzionamento. Tale affidabilità viene valutata essenzialmente con metriche statistiche (bias e varianza), che riconducono a due tipologie di inaffidabilità:

- underfitting ovvero la mancanza di relazione tra l’input (da classificare) e la classe predetta, questo dovuto a un numero non sufficiente di esempi di addestramento oppure non inerenti al contesto uniti ad una rete non strutturata in modo sufficientemente adeguato;

- overfitting quando il modello dimostra un alta precisione con il training set, ma è incapace di generalizzare con nuovi esempi, senz’altro dovuto ad una non buona rappresentazione statistica del problema da parte del training set e a volte anche da una rete sovradimensionata rispetto al tipo di problema.

Evoluzione delle reti neurali

L’impossibilità di replicare il cervello umano è conseguente alla quantità di risorse in termini di memoria e di calcolo che sarebbero necessarie, al momento non disponibili, l’IA infatti è dedicata a svolgere compiti specialistici e specifici utilizzando in modo ottimale le risorse di calcolo. Questa esigenza ha fatto nascere poi:

- reti neurali convoluzionali (CNN) che si basano sull’operazione matematica di convoluzione e che sono utilizzate prevalentemente per il riconoscimento di oggetti e vocale, in generale quando è necessario trovare dei pattern specifici nelle informazioni ;

- reti neurali ricorrenti (RNN) e a memoria modulabile (LSTM) permettono di avere una memoria dello stato precedente (o degli stati precedenti) e questo permette di predire sulla base di un flusso e della sua “storia”, utilizzata ad esempio per la correzione di testi sulla base del contesto, per la traduzione, ma anche per i chatbot (che permettono di rispondere a quesiti o sostenere una conversazione).

Possono infine essere combinati tra loro diversi tipi di reti in modi altamente creativi ed ingegnosi, questo per poter svolgere nuovi compiti gestendo oggetti e dati sempre più complessi, nonchè fornire all’utente finale risposte sempre più articolate e complesse. Ed è qui che hanno origine le deep neural networks (reti neurali profonde), unione di diverse reti formate da numerosi strati eterogenei.

Futuro e implicazioni etiche

Non siamo qui ad erigerci censori di questa formidabile tecnologia, ma se non gestita bene, i rischi per la società da essa derivanti equivarranno o adirittura supereranno i vantaggi. Primo fra tutti sarà la perdita di posti di lavoro e di potere contrattuale in tutti i settori ad alta ripetitività e/o specializzazione, che se non sarà compensata da misure sociali (reddito universale) porterà a crisi e tensioni sociali deleteree.

Poichè è impossibile che tutta la ricerca si autoregoli dal punto di vista etico, è assolutamente prima di tutto necessaria una normazione globale:

- sulla brevettabilità degli algoritmi che riguardano attività di reddito umane, quanto più quanto esse siano svolte da una fetta più rilevante di popolazione, lasciando tutte queste tecnologie aperte e a disposizione di tutti;

- sull’utilizzabilità dell’IA in campo militare e il grado di autonomia ad essa assegnata, per evitare che l’IA scateni guerre o solo lanci in completa autonomia attacchi militari all’interno di un conflitto.

Per il resto l’IA se usata bene, sarà sempre più a nostra disposizione per la nostra salute fisica e mentale, per svolgere le nostre mansioni in modo più efficiente, per aiutarci nelle faccende di tutti i giorni e quindi in generale per migliorare la qualità del nostro tempo.

Studio Cerello & Chesini srl © 2023